Adaptacja artykułu “Co satelity mówią o ociepleniu atmosfery” Nauki o Klimacie

Często tak jest, że fotony promieniowania w podczerwieni są wychwytywane nie tylko z niżej (cieplejszej) troposfery, ale i z wyżej położonej (chłodniejszej) stratosfery. Co już jest przyczyną, że odnosimy wrażenie, że Ziemia jest chłodniejsza niż myśleliśmy dotąd. Tego niestety nie wiedzieliśmy na początku badań troposfery.

Niestety ten mylny obraz przedstawiony w 1990 r. przez pracowników NASA, Roya Spencera i Johna Christy’ego będących zwolennikami metod pomiarowych Ziemi za pomocą satelitów stał się również doskonałym paliwem do powstania silnego denializmu.

Pozorne ochłodzenie troposfery zarejestrowały pierwsze radiometry MSU zamieszczone na satelitach NOAA i wykonujące pierwszą satelitarną serię danych temperatury troposfery.

“Seria ta, popularnie określana akronimem UAH (od nazwy uniwersytetu gdzie zatrudniony był Christy – The University of Alabama in Huntsville), skonstruowana była w oparciu o tzw. temperaturę jasnościową (czyli temperaturę, jaką miałoby ciało doskonale czarne emitujące tyle samo promieniowania co obserwowany obiekt) zmierzoną na kanale 2 MSU (53,74 GHz).”

Na początku lat 90 globalne ocieplenie uznało już większość naukowców, ale niestety błędne pomiary satelitarne wprowadzały wiele zamieszania. Pomiary naziemne nie były też doskonałe. Krytykowano je często za tzw. efekty miejskich wysp ciepła (John Arnfiels, 2003) niby mające zaburzać obliczanie średniej temperatury powierzchni Ziemi i dolnej troposfery, co było oczywiście nieprawdą, ale wykorzystywaną przez środowisko denialistów oraz lobby paliwowo-energetyczne.

Pomiary Spencera i Chrisy’ego, w których wielu krytyków zauważyło, że jest mierzona nie tylko temperatura troposfery, ale i stratosfery (co obniżało ją w rażący sposób mając na względzie także temperaturę powierzchni Ziemi), skłoniło obu naukowców do stworzenia nowej metody badawczej polegającej na skonstruowaniu “syntetycznego” kanału 2RT, później nazwany 2LT, a jeszcze później TLT mającego na celu wyizolowanie emisji troposferycznej od emisji stratosferycznej [7].

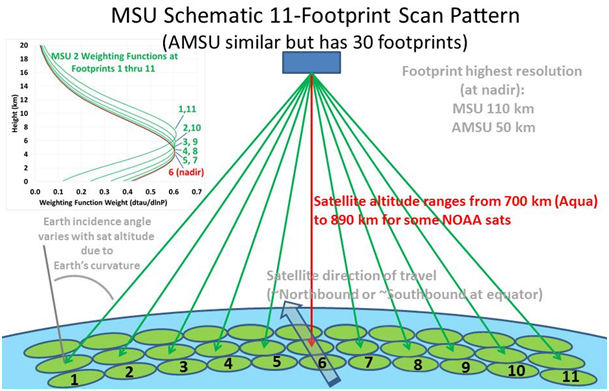

Kanał ten powstał jako kombinacja pomiarów wykonanych pod różnymi kątami względem powierzchni Ziemi. Np. Radiometr miał za jego pomocą odjąć odleglejsze od powierzchni Ziemi i pod mniejszym kątem padające pozycje 1,2 i 11,12 od bliższych powierzchni Ziemi i pod większym kątem padających pozycji 3,4 i 8,9. A więc, miały być wyizolowane środkowe pozycje 5,6,7. (Rysunek poniżej)

Rysunek 1. Stary sposób konstrukcji serii temperatur dolnej troposfery w analizie UAH. Przy większym kącie pomiaru promieniowanie musi pokonać dłuższą drogę przez atmosferę, zatem opisująca je funkcja wagowa jest przesunięta ku wyższym warstwom atmosfery. Kanał 2RT/2LT/TLT powstawał poprzez odjęcie, z odpowiednimi wagami, temperatury jasnościowej zmierzonej przy większym kącie (pozycje 1, 2, 10 i 11 radiometru), od temperatury zmierzonej przy mniejszym kącie (bliżej nadiru, pozycje 3, 4, 8 i 9). Źródło.

Metoda ta okazała się jednak mało skuteczna, ponieważ zmniejszyła się dokładność pomiaru (zarówno jeśli chodzi o rozdzielczość przestrzenną, jak i stosunek sygnału do szumu w zmierzonej temperaturze jasnościowej), oraz zwiększył się wkład emisji z powierzchni Ziemi w promieniowanie rejestrowane przez satelity.

Szczególnie kłopotliwe są pomiary nad obszarami polarnymi, gdzie występowanie lodu jest przyczyną zakłóceń i powstawania szumów w rejestracji fal w podczerwieni [8].

W 2004 r. inny zespół badawczy postanowił wykorzystać inną metodę pomiarową, wykorzystując do tego kombinację dwóch różnych kanałów radiometru: 2 i 4 MSU oraz 5 i 8 AMSU-A [9].

Od tamtej pory, metoda ta uzyskała szerokie zastosowanie w seriach pomiarowych RSS, a Spencer i Christy dopiero zaczęli jej używać od 2015 r.

Błędy w obliczeniach biorą się gdy nie uwzględni się ważnego znaczenia dryfu orbit, którymi przemieszczają się non stop satelity wykonujące pomiary temperatury (J. J. Pocha, 1987).

“W ciągu kilku-kilkunastu lat przebywania satelity na orbicie zwykle powoli dryfuje on w kierunku wschodnim albo zachodnim, przez co przelatuje on nad tym samym punktem w innym czasie (później albo wcześniej). Ponieważ temperatura atmosfery zmienia się w cyklu dobowym, zatem dwa pomiary wykonane w odstępie 10 lat, jeden na przykład wczesnym popołudniem, a drugi na przykład wieczorem, oprócz długoterminowego trendu klimatycznego będą też zawierać, zwykle znacznie większy, wkład dobowej zmiany temperatury. [12]”

Początkowo tak postąpili właśnie Spencer i Christy, ale później skorygowali swoje błędy, które i tak nie zostały do końca poprawione [13].

Pomiary temperatury (teledetekcja) w oparciu o promieniowanie mikrofalowe wydawały się początkowo poprawne, gdyż nie trzeba było w nich uwzględniać znaczenia chmur w atmosferze Ziemi.

W 1990 roku naukowcy ci oszacowali, że wpływ emisji z innych niż tlen komponentów atmosfery, oraz wpływ refrakcji mikrofal na cząsteczkach wody w chmurach i deszczu jest znacznie mniejszy niż 0,01°C w przypadku globalnych anomalii miesięcznych. Ostatnie badania mówią jednak wyraźnie, że nieuwzględnienie obecności chmur mocno zaniża trendy zmian temperatur troposfery o 20-30% [14].

Wniosek z tego płynie taki, że satelitarne pomiary temperatury powierzchni Ziemi niedokładnie obrazują globalne ocieplenie w przeciwieństwie do pomiarów meteorologicznych z urządzeń naziemnych i nawet z urządzeń oceanicznych mierzących temperaturę w oceanach.

“W 37-letniej serii temperatur TMT, opracowanej na podstawie tych samych danych wejściowych, trend liniowy wynosi zaledwie 0,07°C na dekadę w analizie UAH, 0,08°C na dekadę w analizie RSS, i 0,12°C na dekadę w analizie NOAA STAR”.

TMT (temperature in the middle troposphere) (Xuanze Zhang i in., 2015), są kombinacją temperatury jasnościowej mierzonej przez stare radiometry MSU (kanał 2) oraz, od roku 1998, nowsze AMSU-A (kanał 5).

Okazuje się, że również, że nie tylko pomiary naziemne w stacjach meteorologicznych, ale i za pomocą radiosond unoszonych przez balony meteorologiczne chociaż nie są całościowe, gdyż nie wykonuje się ich nad obszarami polarnymi i nad rozległymi oceanami, to i tak są dość dokładne.

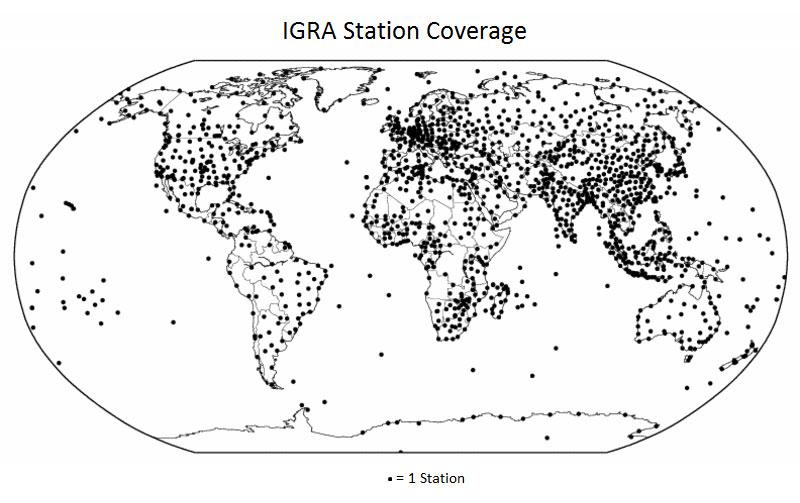

Rysunek 2. Stacje sondowania atmosfery na świecie. Ilustrację zamieszczamy dzięki uprzejmości NOAA.

Radiosondy zainicjowane w użyciu przez WMO są dwa razy dziennie wypuszczane w jednakowym czasie (w okolicy północy i południa czasu Greenwich), z ponad 600 stacji na całym świecie, a uzyskane w ten sposób dane o stanie globalnej atmosfery (troposfery) są następnie wykorzystywane w tworzeniu modeli numerycznych prognozujących pogodę (Phil Jones, Keivin Trenberth i in., 2004).

“Mierzony przez radiosondy od 1958 roku długoterminowy trend temperatury globalnej wynosi 0,14°C na dekadę [15]. W tropikach jest nawet wyższy, i wynosi 0,25°C na dekadę [16].”

Na szybsze ocieplanie się tropikalnej troposfery wskazuje również niedawno opublikowana analiza prędkości wiatrów [17].”

Chociaż serie pomiarowe naziemne różnią się, to i tak dość dobrze są skalibrowane (dopasowane). Dopiero w ostateczności uzupełniane pomiarami satelitarnymi w metodzie Kevina Cowtana i Roberta G. Waya (2014) zwanej krigingiem.

Niestety Roy Spencer stał się osobą zaprzeczająca antropogenicznym zmianom klimatu i wraz z Johnem Christy do dziś uważają obaj, że błędem jest nieuwzględnianie pomiarów satelitarnych względem postępującego globalnego ocieplenia.

Pod numerami w nawiasach – źródła naukowe są zamieszczone w artykule Nauki o Klimacie