Wieczna zmarzlina to bogata w węgiel zamarznięta gleba, która pokrywa 24% powierzchni lądowej półkuli północnej, obejmując rozległe obszary Alaski, Kanady, Syberii i Grenlandii.

Po raz pierwszy rozmarzanie zmarzliny zaobserwowano w latach 90 XX wieku. A więc, kiedy naukowcy zauważyli wyraźnie, że ostatnia dekada ubiegłego wieku mocno ociepliła się, po tym jak ludzkość podjęła się na początku wspomnianej dekady redukcji zanieczyszczeń przemysłowych, takich jak związki siarki i azotu, które będąc gazami chłodzącymi tworzyły wraz z pyłami duże zachmurzenie nad wieloma regionami przemysłowymi, dzięki czemu mniej światła słonecznego dochodziło do powierzchni Ziemi i mniej przez to była ogrzewana powierzchnia Ziemi. Ale redukcja tych aerozoli oznaczała rozjaśnienie nieba i większy dopływ promieniowania słonecznego, czyli większe nagrzewanie planety przy rosnącym stężeniu gazów cieplarnianych. Okazało się, że to nagłe ocieplenie globu ziemskiego uderzyło z dużym impetem w Arktykę i właśnie w zmarzlinę znajdującą się w głębi tajgi i tundry i też nad wybrzeżami zmarzliny lądowej, a także podmorskiej, na szelfach kontynentalnych. W tym ostatnim przypadku, dotyczy to wód syberyjskich, a konkretniej Morza Łaptiewów i Morza Karskiego. Kiedy dobiegł końca ostatni glacjał Würm (115-11,7 tys. lat temu), Ocean Arktyczny i przybrzeżne morza wokół Eurazji i Ameryki Północnej oraz Grenlandii zaczęły podnosić swój poziom, zalewając wiele obszarów suchej zmarzliny na szelfach kontynentalnych

W 2020 roku dr Sayedeh Sara Sayedi i starszy badacz dr Ben Abbott z Brigham Young University (BYU) w Provo w Stanie Utah oszacowali, że podmorska wieczna zmarzlina zawiera około 560 gigaton węgla (GtC – gigatonnes carbon), czyli 170-740 GtC [w przedziale ufności 90%] w samej materii organicznej (OM – organic matter) wraz z organicznym węglem (OC – organic carbon) oraz 45 GtC, czyli 10-110 GtC [w przedziale ufności 90%] w samym tylko metanie (CH4). Z kolei aktualne strumienie CH4 i dwutlenku węgla (CO2) w słupie wody oszacowano na 18 (2-34) i 38 (13-110) megaton węgla (MtC – megatonnes) przez rok czasu (C / rok) 1.

Fot.1. Klatrat metanu (Wikipedia).

Rys.1. Szacunki ekspertów skumulowanych emisji gazów cieplarnianych w ekwiwalentach CO2 (CO2e) z podmorskiej domeny wiecznej zmarzliny dla scenariuszy emisji RCP2.6, RCP4.5 i RCP8.5. Mediana dolnych, środkowych i górnych oszacowań jest reprezentowana przez ciągłe czarne linie, z szarym wypełnieniem między nimi, co oznacza jakościowy 90% przedział ufności. Względne udziały metanu (CH4) (znormalizowane do CO2e) i CO2 tylko dla oszacowań centralnych są pokazane w kolorze różowym i niebieskim. Dla porównania, żółta przerywana linia pokazuje skumulowany CO2e, gdyby emisje z podmorskiej zmarzliny miały pozostać na obecnym poziomie do 2300. Szczegółowe dane i obliczenia w tabeli S5 (Sayedi S. S. i in., 2020)

Autorzy pracy powiedzieli w swojej pracy wprost:

Szelfy kontynentalne Oceanu Arktycznego i otaczających go mórz zawierają duże zapasy materii organicznej (OM) i metanu (CH4), co stanowi potencjalne sprzężenie zwrotne ekosystemu ze zmianą klimatu, nieuwzględnione w międzynarodowych porozumieniach klimatycznych.

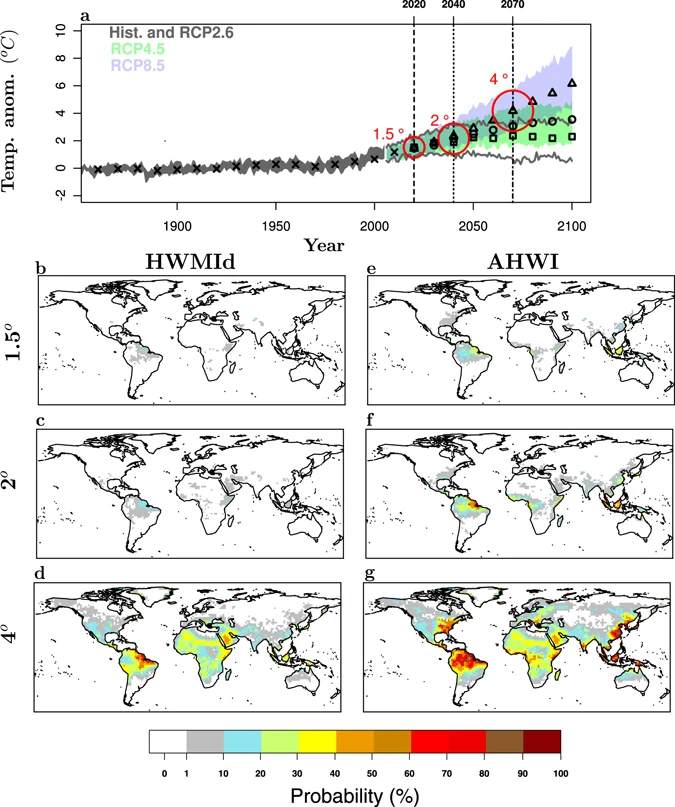

Aby porównać ogólne wymuszanie klimatu z podmorskiej zmarzliny naukowcy przeliczyli emisje metanu (CH4) na ekwiwalent (równoważnik) dwutlenku węgla (CO2e), stosując 100-letni współczynnik przeliczeniowy z potencjałem cieplarnianym 28-krotnie większym dla metanu w horyzoncie czasowym 100 lat uwzględnionym w Piątym Raporcie Oceny IPCC (Schuur i in . 2013 , Abbott i in . 2016 ). Po przeliczeniu [tabela S5 w artykule], CH4 odpowiadał za ponad połowę całkowitego wymuszania klimatu, stanowiąc średnio 65%, 67% i 72% skumulowanych uwolnień CO2e dla RCP2.6, RCP4.5 i RCP8.5, odpowiednio (rys.1.).

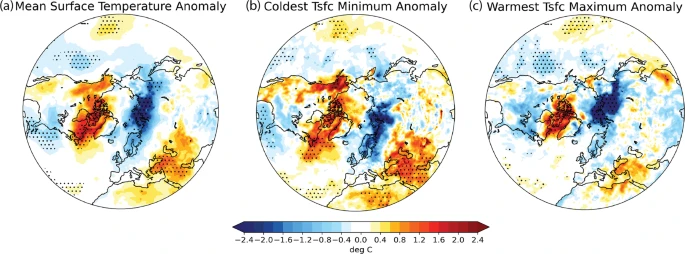

Rys.2. Arktyczna zmarzlina (permafrost).

1/5 zamarzniętych gleb na wysokich szerokościach podlega nagłemu i nieustannemu odmrażaniu (tajaniu), doprowadzając do osuwisk i powodzi, co skutkuje uwalnianiem węgla do atmosfery.

Poziomy gleb bogatych w węgiel – kilogramy węgla na metr kwadratowy

Kg C/m2

a) nagłe odmrażanie:

> 139 (8%) ; 139-105 (10%) ; 104-70 (60%) ; 69-36 (19%)

b) stopniowe odmrażanie:

>139 (4%) ; 139-105 (3%) ; 104-70 (26%) ; 69-36 (39%)

—-

- North Slope, Alaska, USA

Nagłe rozmrażanie powoduje osuwiska i erozję gór.

- Cieśnina Dmitrija Łaptiewa, półnowschodnia Syberia

Wieczna zmarzlina zawierająca grube warstwy lodu gruntowego zapada się nagle, gdy lód się topi.

- Nizina Zatoki Hudsona

Rozmrażanie torfowisk może spowodować uwolnienie dużej ilości węgla.

- Tavvavuoma, północna Szwecja

Narastające jeziora roztopowe są głównym źródłem metanu.

Kierownik katedry badań kanadyjskich na Wydziale Biologii Integracyjnej Uniwersytetu Guelph w Kanadzie, Meritt R. Turetsky, wraz ze swoimi współpracownikami, dokonał głębszej analizy dotyczącej rozmrażającej się zmarzliny lądowej, ostrzegając świat przed grożącym podwojeniem ocieplenia klimatu przez coraz szybciej uwalniające się z niej gazy cieplarniane 2.

Na wstępie swojej pracy naukowcy napisali tak:

Gdy temperatura gleby wzrasta powyżej zera, mikroorganizmy rozkładają materię organiczną w glebie. Gazy cieplarniane, takie jak: dwutlenek węgla, metan i podtlenek azotu – są uwalniane do atmosfery, przyspieszając globalne ocieplenie. Gleby w regionie wiecznej zmarzliny zawierają dwa razy więcej węgla niż atmosfera – prawie 1600 miliardów ton.

W skład wiecznej zmarzliny wchodzą różnego rodzaju gleby, skały lub osady, często wymieszane z dużymi bryłami lodu. Na Ziemi, na półkuli północnej, jest około ¼ gleb zamarzniętych w ten sposób. Węgiel w nich gromadził się przez okresy długich tysiącleci, dlatego, że materia organiczna, składająca się ze szczątków martwych roślin, zwierząt i mikroorganizmów, nie uległa rozkładowi.

Naukowcy dalej napisali:

Modelarze próbują przewidzieć, ile tego węgla zostanie uwolnione, gdy topi się wieczna zmarzlina. Jest to skomplikowane: na przykład muszą zrozumieć, ile węgla w powietrzu zostanie pobrane przez rośliny i zwrócone do gleby, uzupełniając część utraconych. Prognozy sugerują, że powolne i stałe rozmrażanie spowoduje uwolnienie około 200 miliardów ton węgla w ciągu najbliższych 300 lat w ramach scenariusza emisji „biznes jak zwykle”. Odpowiada to około 15% całego węgla w glebie gromadzonego obecnie na zamarzniętej północy.

Zespół naukowy Meritta stwierdził, że powinno być wdrożone więcej badań dotyczących klimatu i gleby, w nurtującej kwestii, ile i skąd będą pochodzić największe emisje gazów cieplarnianych, takich jak: dwutlenek węgla, metan i podtlenek azotu.

Nadal jest słabo poznana erozja rozmrożonych gleb na zboczach wzgórz, gdyż zapadające się zbocza są trudne do wykrycia za pomocą satelitów i tylko przeprowadzono kilka badań tego typu na dużą skalę. Dlatego też naukowcy muszą ustalić, ile węgla z wiecznej zmarzliny przemieszcza się po rozmrożeniu, no i co dzieje się dalej z tym węglem. Na przykład nadal nie wiadomo, ile pozostanie go w ziemi i zostanie w niej zakopane, a ile dostanie się niestety do atmosfery już jako gaz cieplarniany. W warunkach tlenowych jako dwutlenek węgla, a w warunkach beztlenowych jako metan. No i też badacze rozważają, co się stanie z tym węglem, jeśli dostanie się do naturalnych jezior, rzek czy estuariów?

Dalej, wspomniani naukowcy analizują w jakim stopniu wzrost roślin mógłby zrównoważyć węgiel uwalniany przez wieczną zmarzlinę, która rozmarza i zapadając się tworzy specyficzne jeziora, tak zwane termokrasowe. Wiadomo już, że z biegiem czasu te jeziora są zarastane przez rośliny mokradłowe, które ostatecznie mają tendencje do osuszania i przekształcania tychże jezior z powrotem w tundrę. A obszary zerodowane są kolonizowane skutecznie przez rośliny, co pomaga stabilizować gleby i przyspieszać ich regenerację, tym bardziej, że wzrost poziomu CO2, wilgotności gleb oraz nutrientów w nich zawartych, sprzyja rozwojowi roślinności i jej nasilonym procesom fotosyntezy. Dlatego też modelarze będą musieli dokładnie szacować procesy biogeochemiczne pod względem przyszłych sprzężeń zwrotnych obiegu węgla pomiędzy gatunkami tundrowymi a przekształcaną geomorfologią w krajobrazie tundry.

Fot.2. Jeziora termokrasowe wzdłuż wybrzeża Arktyki na Alasce, które powstają podczas topnienia lodu i wiecznej zmarzliny. (Steven Kazlowski / NPL).

Na koniec Meritt ze swoim zespołem naukowym stwierdzają fakt, że rozmieszczenie lodu w ziemi jest właśnie głównym czynnikiem wpływającym na losy węgla w wiecznej zmarzlinie. Jednak obserwacje ogólne lodu na ziemi są nieliczne. Bardziej rozpowszechnione są pomiary geofizyczne, które mogłyby stworzyć mapę zagłębień lodu pod powierzchnią, ujawniając, gdzie się koncentruje i jak szybko topi się.

—-

Z kolei niemiecki badacz Boris Biskaborn z Instytutu Alfreda Wegenera, Centrum Badań Polarnych i Morskich im. Helmholtza, wraz ze swoim międzynarodowym zespołem badawczym, po głębszej analizie terenowej stwierdził fakt, że wieczna zmarzlina ociepla się w skali globalnej 3.

Stosując globalny zestaw danych serii czasowych temperatury wiecznej zmarzliny, na podstawie programu Globalna Sieć Lądowa dla Zmarzliny (GTNP – Global Terrestrial Network for Permafrost), naukowcy obliczyli zmiany temperatury w regionach wiecznej zmarzliny w okresie 2007-2016, poczynając od Międzynarodowego Roku Polarnego (IPY – International Polar Year) (2007-2009).

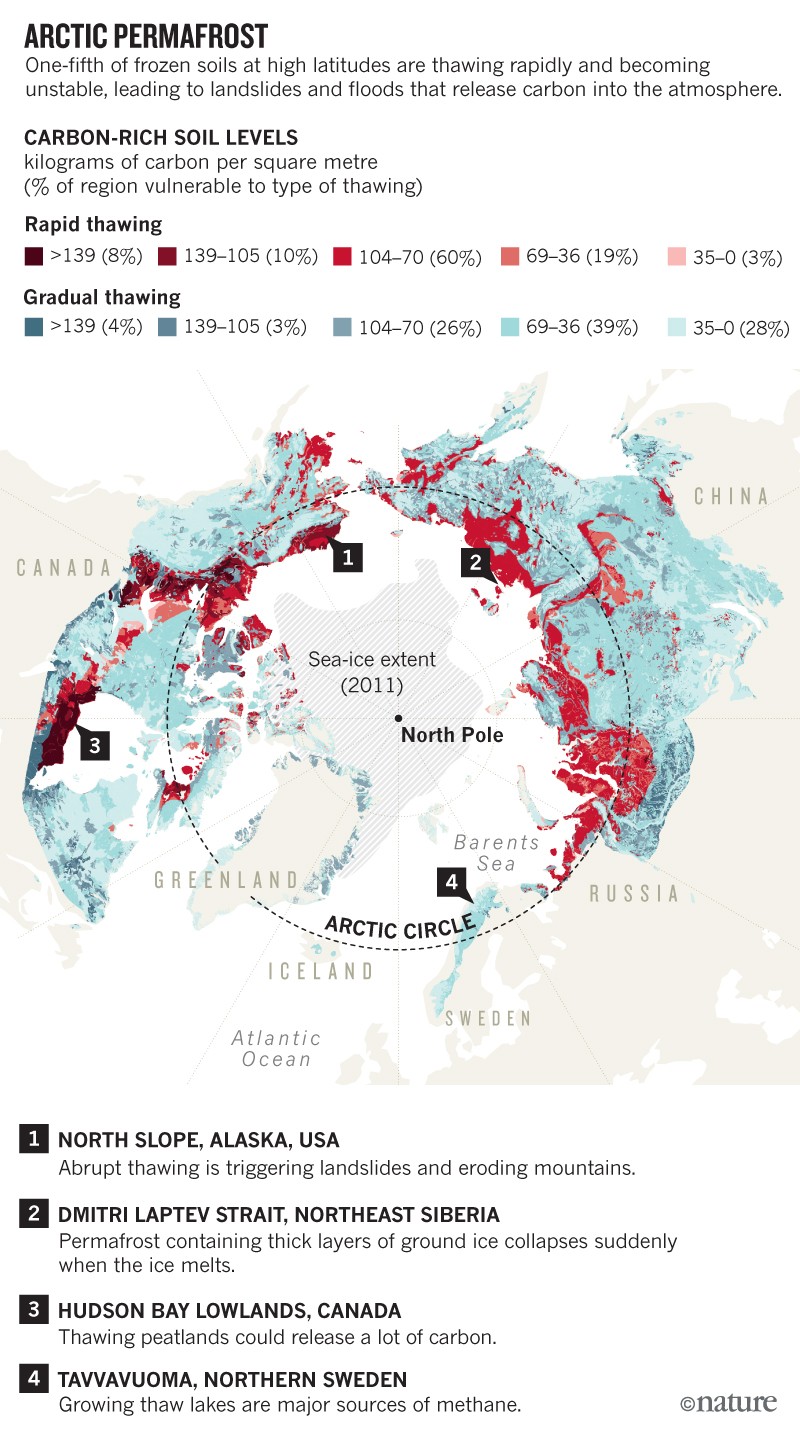

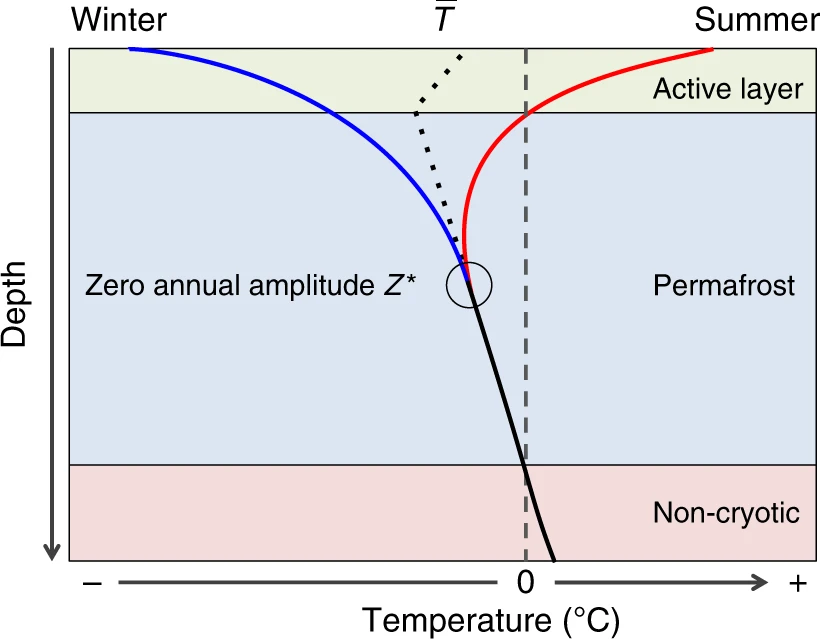

Rys.3. Temperatura wiecznej zmarzliny i tempo zmian w pobliżu głębokości zerowej amplitudy rocznej.

a , b Średnie roczne temperatury gruntu w latach 2014–2016 na półkuli północnej i na Antarktydzie, n = 129 otworów wiertniczych.

c , d Dziesięcioletnie tempo zmian temperatury wiecznej zmarzliny od 2007 do 2016 roku, n = 123 odwiertów.

Zmiany w średniej dokładności pomiaru około ±0,1°C są zaznaczone na zielono.

Strefa ciągłej wiecznej zmarzliny (pokrycie >90%); strefa nieciągłej wiecznej zmarzliny (pokrycie <90%).

Strefy wiecznej zmarzliny pochodzą z mapy Międzynarodowego Stowarzyszenia Zmarzliny (IPA – International Permafrost Association). Dane dotyczące granic świata pochodzą z http://thematicmapping.org/downloads/world_borders.php i na licencji CC BY-SA 3.0 ( https://creativecommons.org/licenses/by-sa/3.0)

Szacunki pokazały wyraźnie, że w latach 2007-2016 temperatura gruntu, znajdującego się w pobliżu głębokości zerowej rocznej amplitudy w strefie ciągłej wiecznej zmarzliny, wzrosła o 0,39 ± 0,15°C. W tym samym okresie, nieciągła wieczna zmarzlina ogrzała się o 0,20 ± 0,10°C. Wieczna zmarzlina w górach ociepliła się o 0,19 ± 0,05°C, a na Antarktydzie o 0,37 ± 0,10°C. W skali globalnej temperatura wiecznej zmarzliny wzrosła o 0,29 ± 0,12°C.

Sami autorzy mówią:

Nasze wyniki pokazują, że w ciągu dekady po IPY wieczna zmarzlina ogrzała się w 71 otworach, w 12 ochłodziła, a w pozostałych 40 pozostała niezmieniona (w zakresie dokładności pomiaru) (Rys.3). Z kolei temperatura gruntu wzrosła powyżej 0°C w pięciu otworach wiertniczych, co wskazuje na rozmarzanie na głębokości pomiarowej 10 m w rocznej amplitudzie zerowej (Z*).

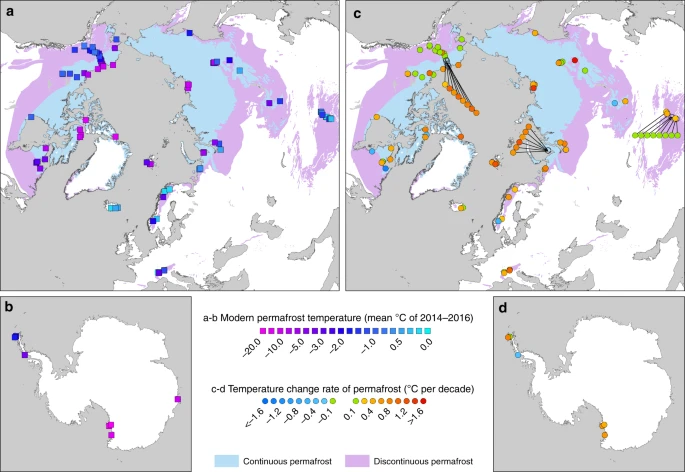

Rys.4. Reżim termiczny wiecznej zmarzliny. Schemat przedstawiający maksymalną (linia czerwona) i minimalną temperaturę gruntu (linia niebieska) w ciągu roku oraz ich zbieżność w celu uzyskania średniej rocznej temperatury gruntu T¯ (Biskaborn B. i in., 2019)

Referencje:

- Sayedi S. S. et al., 2020 ; Subsea permafrost carbon stocks and climate change sensitivity estimated by expert assessment ; Environmental Research Letters ; https://iopscience.iop.org/article/10.1088/1748-9326/abcc29

- Turetsky M. R. et al., 2019 ; Permafrost collapse is accelerating carbon release ; Nature ; https://www.nature.com/articles/d41586-019-01313-4

- Biskaborn B. K. et al., 2019 ; Permafrost is warming at a global scale ; Nature Communications ; https://www.nature.com/articles/s41467-018-08240-4